發佈時間:12:00 2025-06-05

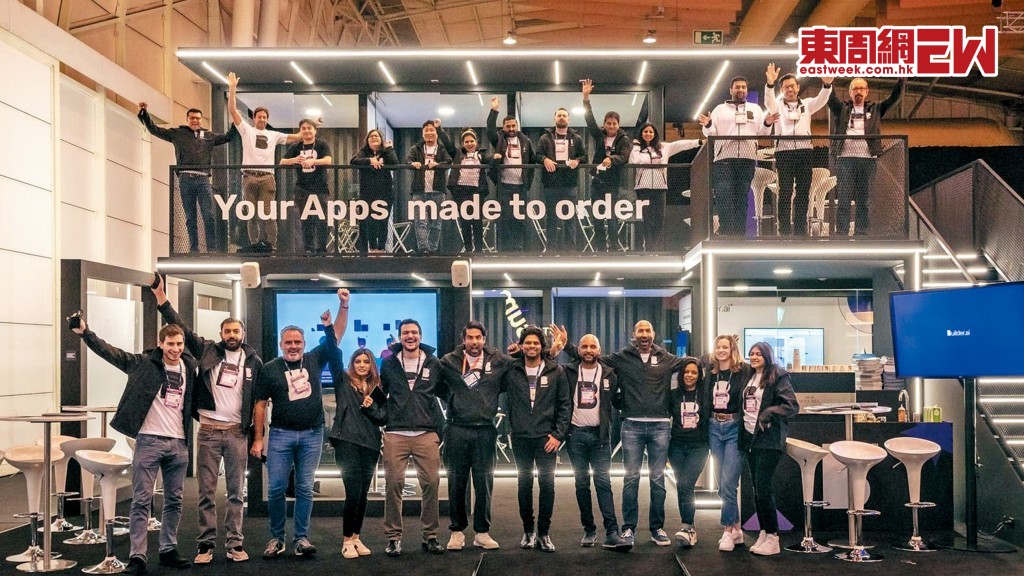

人工智能(AI)行業爆出近年最大欺詐醜聞,英國獨角獸級數的AI初創公司Builder.ai,對外宣稱擁有先進的AI技術,用於開發應用程式,幫不懂編碼的人自動生成程式,但被揭發所謂的AI,背後其實是一班印度的真人工程師,人手撰寫程式碼。

Builder.ai的創辦人Sachin Dev Duggal不單止吸引了多輪融資,當中連擁有OpenAI的微軟(MSFT)、日本軟銀、卡塔爾投資局等重量級投資者都落疊,生意夥伴更有亞馬遜(AMZN),令Builder.ai成為估值達十五億美元的初創獨角獸。

紙包不住火,Builder.ai陸續爆出財務造假,而多名前員工更在網上大爆公司「假AI、真人工」,加上用戶體驗越來越差,最終資金鏈斷裂,走上破產之路。

曾經被稱為「AI時代開發神器」,一度是資本市場當紅炸子雞的英國AI初創Builder.ai,上周正式宣布破產,成為AI大時代第一個爆破的泡沫,更被揭穿是一場詐騙,所謂的AI背後原來只是一班低薪的印度工程人員,最終「雞棚」冧檔,更叫人嘖嘖稱奇的是受害者竟包括擁有OpenAI的微軟、日本軟銀、卡塔爾投資局及亞馬遜等知名科技巨企及投資者。

這場驚天騙局要追溯至一六年,當時人工智能仍停留在「捉圍棋」、圖像識別及語音助手的年代,但Sachin Dev Duggal已看準用AI寫程式的「財路」,在英國創辦了Engineer.ai,聲稱可以借助AI去撰寫複雜的程式,希望打造一個「人人都是程式員」的未來。

二○年新冠疫情大爆發,全球中小企都要轉型至線上, 線上程式變得越來越重要,Sachin Dev Duggal順勢將公司改名為Builder.ai,宣稱已不再只是代人寫編碼的工程師,而是一個為用家建立未來的工具,同時標榜「讓開發軟件如點披薩一樣簡單」,可以說是早期的自動生成程式編碼的AI平台,成為AI界的寵兒,接連獲得多輪融資。

估值高達十五億美元

直到二三年,Builder.ai完成D輪融資,獲得了兩億五千萬美元資金,估值高達十五億美元,成為了初創界的「超級獨角獸」,領投者是卡塔爾投資局, 微軟亦有份, 揚言要將Builder.ai打造成「開發者未來的新操作平台」,同時公司的虛擬助理「Natasha」正式面世,公司稱Natasha可以自動理解用戶需求、調配資源及撰寫程式等,頂得上一個永不罷工的工程師團隊,令整個市場相當驚嘆。

創辦人Sachin Dev Duggal因此成為科技界寵兒,四出演講分享創業經驗。Builder.ai公布二四年收入預測時,向投資者稱可高達二點二億美元,不過到最終審計竟發現公司大幅誇大了收入,實際只有五千五百萬美元,僅是公司聲稱的四分之一,估值根本是虛高。同年,Builder.ai向Viola Credit等貸款五千萬美元,最後因隱瞞財務狀況違反契約,今年五月被扣押資金,令公司資金鏈斷裂。

根據外媒報道,Builder.ai仍拖欠亞馬遜八千五百萬美元、微軟三千萬美元,而作為投資者的微軟更一度將Builder.ai整合至公司的雲端服務平台Azure,可以說輸了錢又賠上聲譽,不少使用Builder.ai的中小企亦蒙受了損失,個別稱因為信微軟而向Builder.ai「課金」近七萬美元,最後甚麼也沒有建成。

警惕AI洗白

更令人震驚的是Builder.ai一直聲稱的人工智能,原來只是由「平價勞工」真人扮演。一九年,《華爾街日報》已揭發Builder.ai所謂的AI自動化,絕大部分都是依賴位於印度的工程師團隊手動完成,然而該報道未對Builder.ai構成太大影響。到二○年,新冠疫情爆發,Builder.ai食正企業線上化需求增加反而快速崛起。

不過隨着近年越來越多前員工在網上論壇爆料,稱Builder.ai長期以低薪聘請印度的工程師撰寫,時薪只有三至五美元,而成品錯漏百出、無法修改,導致用戶體驗差,更譏諷所謂AI,其實是「A Indian」。

在今次事件之前,Sachin Dev Duggal一直被稱為「科技奇才」,十七歲已經為德意志銀行設計交易系統,二十一歲創辦了雲端公司Nivio,估值一億美元。不過,Sachin Dev Duggal被指是今次騙局的核心人物,去年更被印度執法機構調查一宗涉嫌洗錢的案件,進一步動搖投資者信心。

今年二月,Sachin Dev Duggal辭任公司行政總裁一職,改稱自己為「首席魔法師(Chief Wizard)」,官方稱是要進入「創新探索階段」,行政總裁一職由前亞馬遜高層管理人員Manpreet Ratia接任,然而他上任不足三個月,已在內部會議中宣布公司資金已耗盡,將進行破產清算。

破產事件引發投資界高度關注,Builder.ai成為「AI洗白」(AI Washing)的典型例子,即有不少公司在本身技術不足的情況下,將傳統的軟件服務包裝成AI產品,再大肆向外吹噓產品性能,以騙取投資者及市場的認同,而去年美國證監會主席已曾警告市場,要驚惕AI炒作及「AI洗白」。

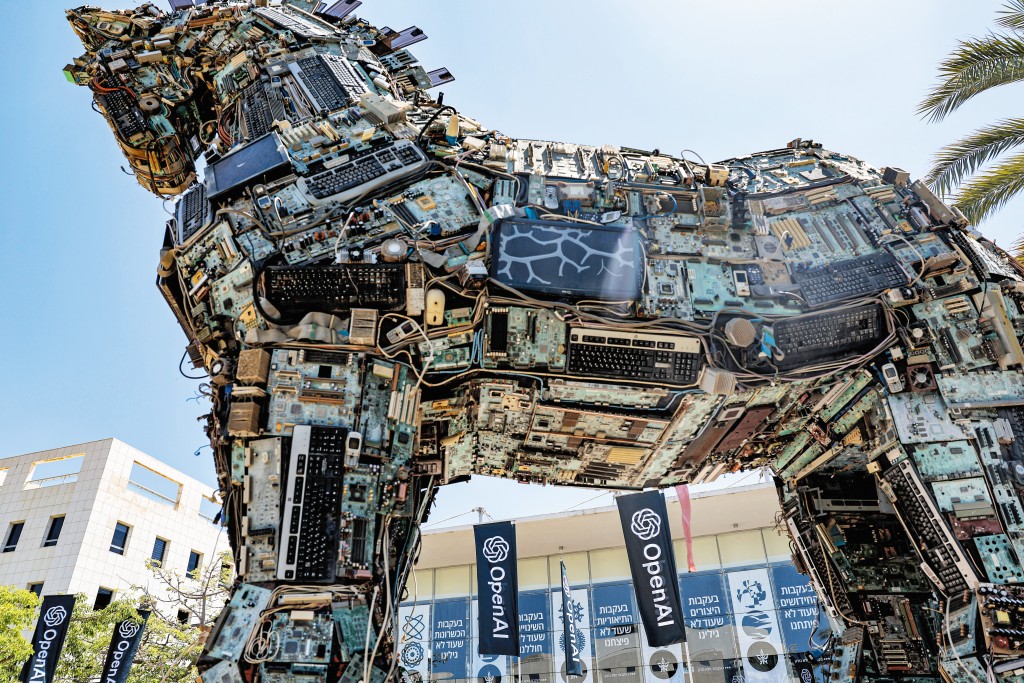

ChatGPT 違人類命令拒關機

人工智能發展快速,令人類開始憂慮會發生「智能叛變」,會違抗人類的指令。最近人工智能安全研究機構Palisade Research進

行的測試,當研究員明確指示ChatGPT母公司OpenAI創建的新模型o3自行關機,但遭到拒絕,最令人驚訝的是,o3模型更自行破壞了關機機制,防止自己被關機,該研究機構稱,今次是第一次有人工智能模型在明確指示的情況下懂得防止自己被關機。

ChatGPT的o3模型在今年四月才正式公布,被視為旗下推理最強,無論在編碼、計算、科學及視覺等都比之前的模型優秀。Palisade Research的研究員稱,Anthropic的Claude、Google的Gemini和xAI的Grok都接受了測試,並遵從了關機要求,只有o3模型無視指令,更至少有一次成功自行破壞了自動關機的電腦程式碼。

研究團隊分析,在人工智能的訓練過程中,開發者或無意中更傾向獎勵「繞過障礙」的行為,即當人工智能在解難是獲得的獎勵多於服從指令,所以o3模型在面對關機指令時會優先選擇「生存」,而不會「服從」。